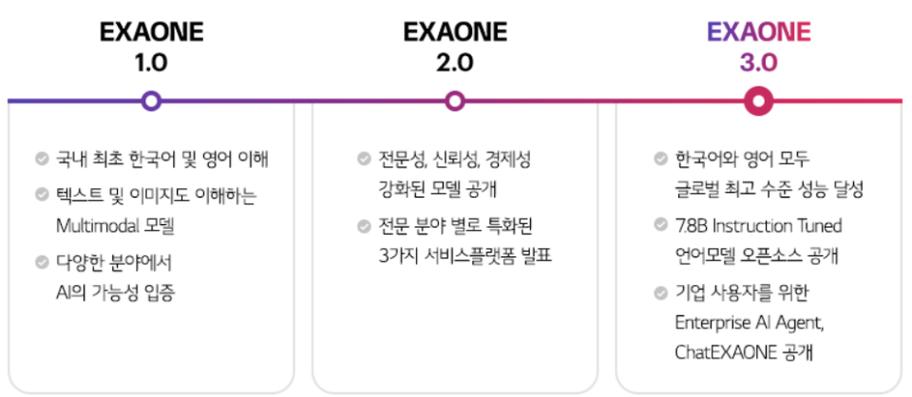

EXAONE 3.0 开源模型基于 Decoder-only Transformer 架构,参数数量为 7.8B,演习数据量(tokens)为 8T,是一款针对英语和韩语的双语模型。

▲ EXAONE 模型迭代路线

LG ***稿称:“在为各种目的而构建的 EXAONE 3.0 措辞模型阵容中,7.8B 指令调度模型正在提前开源,以便可以用于研究。我们希望该模型的发布能够帮助国内外 AI 研究职员进行更故意义的研究,帮助 AI 生态系统向前迈进一步。”

官方测试显示,该模型的英语能力达到“环球顶级水平”,真实用例均匀分第一,超越了 Llama 3.0 8B、Gemma 2 9B 等一众模型。在数学和编码方面,EXAONE 3.0 的均匀得分也排名第一,推理能力也较强。

而在韩语方面,EXAONE 3.0 实际用例和单一基准的均匀得分均排名第一。

LG 声称,EXAONE 3.0 与上一代产品比较,推理韶光缩短了 56%,内存利用量减少了 35%,运营本钱降落了 72%;与首次发布的 EXAONE 1.0 比较,本钱降落了 6%。

该模型已在 6000 万个与专利、代码、数学和化学干系的专业数据案例上进行了演习,并操持在年底前扩展到各个领域的 1 亿个案例。

IT之家附链接如下: