编辑:Panda W

图像天生、视频天生、整合语音合成的人脸动画、天生三维的人物运动以及 LLM 驱动的工具…… 统统都在这篇文章中。

天生式 AI 已经成为互联网的一个主要内容来源,现在你能看到 AI 天生的文本、代码、音频、图像以及视频和动画。本日我们要先容的文章来自主陶宛博主和动画师 aulerius,个中按层级先容和分类了动画领域利用的天生式 AI 技能,包括简要先容、示例、优缺陷以及干系工具。

(图片来自网络侵删)他写道:「作为一位动画制作者,我希望一年前就有这样一份资源,那时候我只能在混乱的互联网上自行探求可能性和不断涌现的进展。」

本文的目标读者是任何对这一领域感兴趣的人,尤其是不知如何应对 AI 领域新技能发展的动画师和创意人士。另需解释,视频风格化虽然也是干系技能,但本文基本不会涉及这方面。

本文的文章构造。

图像天生

图像天生技能是指利用 AI 模型天生图像的技能,这些 AI 模型的演习利用了静态图像。

将天生的图像用作素材

将任意 AI 运用天生的静态图像用作 2D 剪贴画、数字处理、拼贴等传统事情流程中的素材,或者用作其它 AI 工具的资源,比如供应给图像转视频(image2video)工具来天生视频。除了作为图像和素材来源,这类技能还需依赖剪切和图像编辑等一些常用技能。

短片《Planets and Robots》中利用了数字剪贴画来将天生的 AI 图像动画化,个中的配音也是利用 LLM 基于脚本天生的。

视频链接:https://mp.weixin.qq.com/s?__biz=MzA3MzI4MjgzMw==&mid=2650907887&idx=4&sn=ca30f3fbde94ec74b32d75b638013594&chksm=84e46091b393e987d442c8c414bdb9b76741d60116bee3419f36a3cb5961906e5d33b4ab312b&token=1179435113&lang=zh_CN#rd

优点:

现有动画师就很随意马虎上手利用可用于天生背景图缺陷:

天生结果没有多少「新意」须要动画师折衷处理素材和动画免费工具(任何天生图像模型或运用):

Stable Diffusion(SD,运行在本地打算机上)或这些在线运用:CraiyonInvokeai (利用了 SD)Enfugue (利用了 SD)SkyBox AI—— 能天生适用于 VR 的 360 度场景图插件和附加组件:

在 Blender 中利用的 ComfyUI 节点Krita 上的 Stable DiffusionKrita 上的 ComfyUI—— 界面大略易用,对艺术家友好此外,Hugging face space 上还有一些免费的演示:https://huggingface.co/spaces

付费工具(任何天生图像模型或运用):

MidJourneyRunwayDALL・E 2Adobe 的 FireFly注:动画制作利用的工具包括 After Effects、Moho、Blender……

逐帧天生图像

这类技能因此一种相称程度上立足动画根源的精神来利用天生式扩散图像模型,其因此逐帧办法天生动作序列,就像是传统动画制作的绘制再拍摄过程。个中的一大关键是这些模型在天生每张图像时没有韶光或运动的观点,而是通过某种机制或各种运用或扩展来帮助得到某种程度上的动画,从而实现所谓的「韶光同等性(temporal consistency)」。

这些技能得到的动画每每会涌现闪烁征象。只管许多利用这些工具的用户会努力清理这些闪烁,但动画师却会把这视为一种艺术形式,称为 boiling。

这方面最常用的是 Stable Diffusion 等开源模型以及基于它们构建的工具。用户可以利用公开的参数来配置它们,还可以将它们运行在本地打算机上。相较之下,MidJourney 工具的模型没有公开,而且紧张是为图像天生设计的,因此无法用来天生逐帧动画。

视频链接:https://mp.weixin.qq.com/s?__biz=MzA3MzI4MjgzMw==&mid=2650907887&idx=4&sn=ca30f3fbde94ec74b32d75b638013594&chksm=84e46091b393e987d442c8c414bdb9b76741d60116bee3419f36a3cb5961906e5d33b4ab312b&token=1179435113&lang=zh_CN#rd

动画也可能利用 Stable WarpFusion 来制作,这个中涉及到图像转图像的事情流程,通过一些扭变(置换)将底层的视频输入变成动画。视频作者:Sagans。

用逐帧图像来制作动画常日须要稠浊利用以下工具:

一步到位的工具(文本转图像)

有一些新技能支持直接通过文本 prompt 和参数调配来天生动画:

参数插值(变形)在每张天生的图像帧上逐渐进行参数插值,以得到过渡动画。这里的参数可能包括任何与模型干系的设定,比如文本 prompt 本身或底层的种子(隐空间游走)。

prompt 编辑法,即通过逐渐改变权重来创建动画过渡。这里利用了 Depth ControlNet 来保持手部整体形状的同等性。

图像到图像(I2I)反馈循环通过图像到图像技能,将每张天生的图像帧作为输入来天生动画的下一帧。这样在其它参数和种子变革时也可以天生看起来相似的帧序列。这个过程常日由 Deforum 中的「去噪强度」或「强度调度」来掌握。起始帧可以是已有的图片。

这是大多数利用 Stable Diffusion 的动画实现的一个核心组件,而 Stable Diffusion 是下列许多运用依赖的技能。这种技能很难平衡,并且很大程度上取决于利用的采样器(噪音调剂器)。

利用一张起始图像,然后利用一个稍有不同的 prompt,使其逐帧变革成其它形态。

2D 或 3D 变换(基于 I2I 循环)逐渐变换每一帧天生图像,之后再将其作为 I2I 循环的输入。2D 变换对应于大略的平移、旋转和缩放。3D 技能则会想象一个在 3D 空间中移动的虚拟相机,这常日须要估计每帧天生图像的 3D 深度,然后根据想象中的相机运动来进行变形处理。

想必你已经看过这种无限放大的动画。它的视觉效果如此之棒,是由于其利用了 SD 来持续构建新细节。

实验性、运动合成、稠浊等技能运动合成的目标是「想象」后续天生帧之间的运动流,然后利用这个运动流来逐帧实行变形处理,从而基于 I2I 循环注入有机的运动。这常日须要依赖在视频的运动估计(光流)上演习的 AI 模型,只不过其关注的不是后续视频帧,而是后续天生帧(通过 I2I 循环),或是利用某种稠浊方法。

其它技能还包括图像修复和变形技能搭配利用、采取多个处理步骤或乃至捕获模型演习过程的快照等前辈技能。举个例子,Deforum 有很多可供用户调控的地方。

利用 SD-CN Animation 制作,其利用了一种在天生帧之间产生幻觉运动的独特方法。起始图像只是作为出发点,没有其它用场。

变换型技能(图像到图像):

此外还可以利用某个来源的输入来助力天生的帧和所得的动画结果:

稠浊(风格化)—— 稠浊视频源或 / 和按条件处理(ControlNets)这类方法范围很广,做法是利用输入视频来稠浊和影响天生的序列。这些输入视频常日分为多个帧,浸染常日是风格化现实视频。在现如今的风格化舞蹈视频和演出热潮中,这类技能常被用于实现动漫造型和性感体格。但你可以利用任何东西作为输入,比如你自己动画的粗略一帧或任何凌乱抽象的录像。在模拟 pixilation 这种定格动画技能和更换动画技能方面,这类技能有广泛的可能性。

在每一帧,输入帧要么可以直接与天生图像稠浊,然后再输入回每个 I2I 循环,要么可以采取更高等的设定附加条件的做法,比如 ControlNet。

Deforum 搭配 ControlNet 条件化处理的稠浊模式,左图是原视频。掩蔽和背景模糊是分开实行的,与这项技能无关。

光流变形(利用视频输入在 I2I 循环上实行)「光流」是指视频中估计的运动,可通过每一帧上的运动向量表示,其指示了屏幕空间中每个像素的运动情形。当估计出变形事情流程中的源视频的光流后,就可以根据它对天生的帧实行变形,使得天生的纹理在工具或相机移动时也能「粘黏」在工具上。

Deforum 的稠浊模式支持这种技能搭配各种设置利用。为了得到闪动更少的结果,也会增加 cadence,使得变形的效果更好。掩蔽和背景模糊是分开实行的,与这项技能无关。

3D 衍变通过变形事情流程完成的条件处理也可能直接关联 3D 数据,这可以跳过一个可能造成模糊的环节,直接在视频帧上完成处理。

举个例子,可以直接通过虚拟 3D 场景供应 openpose 或深度数据,而不是通过视频(或经由 CG 渲染的视频)估计这些数据。这许可采取最模块化和最可控的 3D 原生方法;尤其是组合了有助于韶光同等性的方法时,效果更佳。

这可能是现有技能与用于 VFX 的 AI 技能之间最有潜力的交叉领域,如下视频所示:https://youtu.be/lFE8yI4i0Yw?si=-a-GvsaIVPrdaQKm

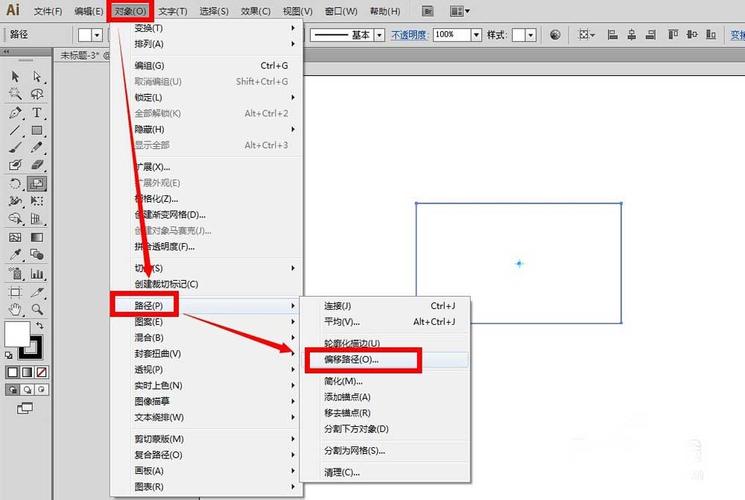

有一个广泛运用的工具也利用了该技能,其可简化并自动化用 Blender 天生直接适用于 ControlNet 的角色图像的过程。在这个示例中,ControlNet 利用手部骨架来天生 openpose、深度和法线贴图图像,终极得到最右侧的 SD 结果。(openpose 终极被舍弃了,由于事实证明它不适用于只有手部的情形。)

将所有这些技能结合起来,彷佛有无尽的参数可以调度动画的天生结果(就像模块化的音频制作)。它要么可以通过关键帧进行「调度」并利用 Parseq 这样的工具绘制图形,要么可以与音频和音乐关联,得到许多随音频变革的动画。只需如此,你就能利用 Stable Diffusion 帮你舞蹈了。

优点:

全新且不断演化的美学风格,这是这种媒体形式特有的。在观点上与传统的动画技能有共同点。最随意马虎定制化、最实用且易于辅导。模块化、分层的方法。缺陷:

每每会有闪动问题,有时候会显得很混乱。技能方面要考虑的东西很多,难以平衡考虑,要想成为高手必须经历陡峭的学习曲线。如果没有性能卓越确当地硬件(英伟达 GPU),就会很未便利。免费工具:

可在 A1111 webui 中利用的工具:

用于参数插值动画(travel)的小脚本:步骤(https://github.com/vladmandic/sd-extension-steps-animation) 、prompt(https://github.com/Kahsolt/stable-diffusion-webui-prompt-travel )、种子(https://github.com/yownas/seed_travel)。Deforum—— 能够知足各种动画 SD 需求的最佳工房,整合了上面大多数技能。Parseq—— 用于 Deforum 的常用视觉参数排序工具。Deforum timeline helper—— 另一款参数可视化和调度工具。Deforumation—— 用于实时掌握 Deforum 参数的 GUI,支持反应性调度和掌握。TemporalKit—— 采取了 EBsynth 的一些原则,可与 SD 搭配利用实现同等的视频风格化。SD-CN Animation—— 这多少还是个实验性工具,支持一些稠浊风格化事情流程,也支持有趣的光流运动合成(这会导致运动抖动)。TemporalNet——ControlNet 模型可以用在 Deforum 等其它事情流程中,目标是提升韶光同等性。Python 条记本(须要在 Google Colab 或 Jupyter 上运行)。Stable WarpFusion —— 实验性的代码工具包,目标是实行高等的视频风格化和动画。与 Deforum 有很多一样的功能。插件和附加组件:

用于 Blender 的 Dream TexturesStabiliy AI 的 Blender 插件看起来像用于 Blender 的 Openpose 的角色骨架 —— 可在 Blender 之外利用 ControlNet用于虚幻引擎 5 的 Unreal Diffusion用于 After Effects 的 After-Diffusion(目前还在开拓中)用于 TouchDesigner 的 A1111 或 ComfyUI API—— 如果你知道如何操作,那么这可用于实行动画等各种任务付费工具:

(常日也依赖于 SD,但运行在「云」上,用起来也更大略):

Stability AI 的动画 APIKaiber 的 Flipbook 模式 —— 按照描述,基于 Deforum 代码插件和附加组件:

用于 After Effects 的 Diffusae市情上还有许多运用和工具,但如果是付费工具,多数是基于开源的 Deforum 代码。

注:最好的情形是你有足够的优秀硬件(即 GPU)在本地运行这些工具。如果没有,你也可以考试测验运行在远程打算机上的、功能有限的免费做事,比如 Google Colab。不过,Google Colab 上的条记本也可以运行在本地硬件上。

视频天生技能

这类技能利用在运动视频上演习的视频天生 AI 模型,其余可以在神经网络层面上利用韶光压缩来增强。

目前,这些模型有一个共同特色是它们仅能处理韶光很短的视频片段(几秒),并受到 GPU 上可用视频内存的限定。但是,这方面的发展速率很快,并且可以用一些方法将多个天生结果拼接成更长的视频。

视频天生模型

这是指利用从头构建和演习的模型来处理视频。

现今的这类模型得到的结果每每晃动很大、有明显的 AI 痕迹、显得古怪。就像是良久之前天生图像的 AI 模型一样。这个领域的发展掉队一些,但进展很快,我个人认为在静态图像天生上取得的进展并不会同等比例地在视频天生方面重现,由于视频天生的难度要大得多。

Paul Trillo 利用 Runway 的 Gen-2,仅通过图像和文本 prompt 让 AI 天生的视频。

视频链接:https://mp.weixin.qq.com/s?__biz=MzA3MzI4MjgzMw==&mid=2650907887&idx=4&sn=ca30f3fbde94ec74b32d75b638013594&chksm=84e46091b393e987d442c8c414bdb9b76741d60116bee3419f36a3cb5961906e5d33b4ab312b&token=1179435113&lang=zh_CN#rd

我认为在这方面,动画和传统电影之间的界线很模糊。只要其结果还与现实有差异,那么我们就可以在一定程度上把它们看作是动画和视频艺术的一种怪异新流派。就目前而言,我认为大家还是别想着用这类技能做真实风格的电影了,只把它视为一种新形式的实验媒体即可。玩得愉快哦!

一步到位的工具(文本转视频):利用文本 prompt 天生全新的视频片段

理论上讲,这类技能有无限可能性 —— 只要你能将其描述出来(就像静态图像天生那样),就可能将其用于直播演出或天生任何超现实和风格化的内容。但从实践角度看,为了演习视频模型,网络多样化和足够大的数据集要难得多,因此仅靠文本来设定天生条件,很难用这些模型实现利基(niche)的美学风格。

利用这种方法,只能很宽松地掌握创意事情。当与图像或视频条件化处理(即变形事情流程)组合利用时,这种技能就会强大得多。

Kyle Wiggers 做的动画天生测试,利用了 Runway 的 Gen-2

变形:利用文本 prompt,再根据已有的图像或视频进行进一步的条件化处理

图像到视频天生很多视频天生工具都能让你以图像为条件天生视频。其做法可以是完备从你指定的图像开始天生,也可以将指定图像用作语义信息、构图和颜色的粗略参考。

人们常常会利用传统的静态图像模型天生起始图像,然后再将其输入视频模型。

这里天生的每一段视频都是利用一张唱片封面作为起始图像,作者:Stable Reel

视频链接:https://mp.weixin.qq.com/s?__biz=MzA3MzI4MjgzMw==&mid=2650907887&idx=4&sn=ca30f3fbde94ec74b32d75b638013594&chksm=84e46091b393e987d442c8c414bdb9b76741d60116bee3419f36a3cb5961906e5d33b4ab312b&token=1179435113&lang=zh_CN#rd

视频到视频天生类似于图像天生模型中的图像到图像过程,也有可能将输入视频的信息嵌入到视频模型中,再加上文本 prompt,让其天生(去噪)输出。

我并不理解这个中的详细过程,但彷佛这个过程不仅能在逐帧层面上匹配输入视频片段(犹如利用 Stable Diffusion 进行风格化处理),而且能在整体和运动层面上匹配。和图像到图像天生过程一样,这个过程受去噪强度掌握。

如果运气好并且有得当的 prompt,你也可以输入视频来「启示」模型重新想象源视频中的运动,并以完备不同的形式将其呈现出来。利用 webui txt2vid 中的 Zeroscope 完成,利用了 vid2vid 模式。

优点:

这类技能具有最大的可能性,并且会随韶光不断改进。在专业动画知识方面没有进入门槛。比较于逐帧的技能,这类技能的结果每每更加平滑,常日也更为同等。对付「变形」事情流程而言,这可能是比逐帧方法更大略直接的方法。缺陷:

得到的结果常日显得离奇怪异,一看便是 AI 天生的,而且这种情形比静态图像严重多了。在涉及人的仿真实影像方面尤其明显。打算本钱高。比较于图像 AI,更难以在本地硬件上运行。存在视频时是非和高下文短等限定(目前而言)。免费工具:

Stable Video (SVD)—— 来自 StabilityAI 的开源视频扩散模型。目前很多托管式运用和工具都在快速支配实现该模型。SVD ComfyUI 实现SVD 韶光 ControlNetMotionCtrl—— 经由增强,许可在各种视频模型中掌握目标运动和摄像机轨迹。Emu Video——Meta 的视频天生模型的预览演示。A1111 webui 的文本转视频插件,可搭配以下模型利用(如果你的硬件足够):VideoCrafterZeroscope插件和附加组件:

用于 Blender 的 Pallaidium—— 一个多功能工具包,包含跨图像、视频乃至音频领域的生成功能。此外,你还能在 Hugging face space 上找到一些免费演示。付费工具(有试用版):

Runway 的 Gen2Kaiber 的 Motion 模式Pika labs(受限 beta 版)注:最好的情形是你有足够的优秀硬件(即 GPU)在本地运行这些工具。如果没有,你也可以考试测验运行在远程打算机上的、功能有限的免费做事,比如 Google Colab,不过大多数免费或试用做事的功能都有限。

利用运动压缩增强的图像模型

随着 AnimateDiff 的日益盛行,涌现了一个利用视频或「运动」压缩来增强已有图像扩散模型的新兴领域。比较于利用逐帧技能天生的结果,其天生的结果更附近于原生视频模型(如上面先容的)。这种技能的上风是你还可以利用为 Stable Diffusion 等图像模型构建的工具,如社区创建的任何检讨点模型、LoRA、ControlNet 以及其它条件化处理工具。

你乃至有可能通过 ControlNet 供应视频条件化处理,就像是利用逐帧技能一样。社区仍在积极实验这一技能。可用的技能有的来自静态图像模型(比如 prompt 遍历),也有的来自视频原生模型。

如下视频为利用 ComfyUI 中 AnimateDiff 完成的动画,过程利用了多个不同的 prompt 主题。

视频链接:https://www.instagram.com/p/Cx-iecPusza/?utm_source=ig_embed&utm_campaign=embed_video_watch_again

这种技能中的运动本身常日非常原始,只是在视频片段中疏松地插入工具和流,这每每会将事物变形成其它样子容貌。不过,这种技能有更好的韶光同等性,而且仍处于起步阶段。当场景很抽象,没有详细物体时,这种方法能得到最好的结果。

优点:

可以受益于现有图像扩散模型的进展。可以通过去噪或利用 ControlNet 用视频来进行条件化处理。处理抽象、流运动效果很好。缺陷:

难以为人物或不常见的物体产生繁芜、连贯同等的运动,反而常涌现变形问题。和视频原生模型一样,打算本钱高。比较于图像 AI,更难以在本地硬件上运行。受限于较短的高下文窗口(目前而言),但也有一些人正在实验办理方案。免费工具:

目前,AnimateDiff (SD v1.5) 的实现一马当先:

用于 AnimateDiff 的 A1111 webui 插件ComfyUI 中 AnimateDiff 实现VisionCrafter—— 一个用于 AnimateDiff 实现等项目的 GUI 工具用于 SD XL:Hotshot-XL多功能实现:Enfugue付费工具:

目前彷佛没有整合语音合成的人脸动画

大家都知道,这是一个盛行迷因背后的技能。你可能看过一个相对静止的人物(相机可能在移动)只有脸动着说话,这多数是用到了 AI 人脸动画化和语音合成工具的组合方法。

这个中组合了多个技能步骤和组件。其源图像多数是利用图像天生 AI 制作的,但也可以利用任何带有人脸的图像。语音是根据文本天生的,并根据所选任务的音色进行了条件化处理。然后再利用另一个工具(或工具包中的某个模型)合成与音频唇形同步的人脸动画 —— 常日只天生图像中脸部和头部区域的运动。利用预演习的数字化身也能让身体动起来。

视频链接:https://mp.weixin.qq.com/s?__biz=MzA3MzI4MjgzMw==&mid=2650907887&idx=4&sn=ca30f3fbde94ec74b32d75b638013594&chksm=84e46091b393e987d442c8c414bdb9b76741d60116bee3419f36a3cb5961906e5d33b4ab312b&token=1179435113&lang=zh_CN#rd

在发布热门的 Belenciaga 视频之前,作者 demonflyingfox 就已经发布了一篇分步教程:https://youtu.be/rDp_8lPUbWY?si=BWNKe7-KTJpCrNjF

优点:

可用于轻松制作迷因动图。…… 呃,有笑剧效果?缺陷:

常日看起来不自然。我还想不出这能有什么实际用场。过于依赖付费运用供应的闭源人脸动画工具。纵然你利用自己的录像来演习数字化身,得到的结果也过于呆板,动态效果很差。免费工具:

ElevenLabs—— 有利用次数限定,但次数彷佛每个月都会刷新。A1111 WebUI 的 Wav2Lip 插件 —— 用于天生唇形同步动画的工具。看起来仅限于嘴部区域。你也可以在网上直接搜索文本转语音做事,不可胜计,但效果多数赶不上 ElevenLabs。

至于全脸动画化,就我所知,目前仅有一些付费运用供应了试用版,而且利用很受限。

付费工具(有试用版):

人脸动画制作(常日会搭配语音合成):

D-IDHeygenSynesthesia搜索「D-ID 替代品」就能找到很多。

天生三维的人物运动

这是指为 3D 人物合成运动的技能。这类技能可以运用于 3D 动画电影、视频游戏或其它 3D 交互运用。正如图像和视频领域一样,新兴的 AI 工具让人可通过文本来描述人物的运动。此外,一些工具还能根据很少的关键姿势来构建运动或者在交互环境中实时动态地天生动画。

视频链接:https://mp.weixin.qq.com/s?__biz=MzA3MzI4MjgzMw==&mid=2650907887&idx=4&sn=ca30f3fbde94ec74b32d75b638013594&chksm=84e46091b393e987d442c8c414bdb9b76741d60116bee3419f36a3cb5961906e5d33b4ab312b&token=1179435113&lang=zh_CN#rd

Nikita 的充满天才巧思的元人工智能电影预报片,个中将 AI 的运动学习过程展现成了一部风趣诙谐的有趣短片。

由于本文的关注重点是天生工具,因此没有包含自动化某些非创意任务的 AI 运用,比如 AI 驱动的运动跟踪、合成、打码等,例子包括 Move.ai 和 Wonder Dynamics。

优点:

能整合进现有的 3D 动画制作流程中,可减少重复性任务,有望成为动画老手的好帮手。能很好地处理物理效果和重量。在未来的视频游戏中实现动态的人物动画?缺陷:

彷佛受限于人类形态的双足式人物。还须要其它工具赞助。只是 3D 动画制作流程的一个组件。你须要知道接下来该做什么。演习过程常日基于人类运动数据,这意味着到目前为止这些工具只能实现基于真实物理效果的运动,无法实现风格化或卡通中的运动机制。免费工具(或可免费利用部分功能的做事):

MootionOmni AnimationCascadeur—— 动画制作助理,可以根据最小化的输入创建平滑的、基于物理机制的动画和姿势。可控性高,可能会成为未来一个主力工具。ComfyUI 中的 MDM、MotionDiffuse 和 ReMoDiffuse 实现。付费工具:

免费工具的付费套餐会供应更多功能,利用限定也更少。LLM 驱动的工具

从理论上讲,由于大型措辞模型(LLM)在编程任务上表现出色,尤其是经由微调之后,那么我们就可以在制作动画的软件中让其编程和编写脚本。这就意味着按照常规事情流程制作动画时,能让 AI 从头到尾一贯赞助。极度情形下,AI 能帮你完成统统事情,同时还能为后端流程分配适当的任务。

在实践中,你也能考试测验这么做了!

举个例子,Blender 配备了非常广泛的 Python API,许可通过代码操作该工具,因此现在已经有几个类似 ChatGPT 的赞助工具可用了。这个趋势不可避免。只要有代码,LLM 多数就会有用武之地。优点:

潜力 —— 终极打破创意事情者面临的任何技能障碍。可用作创意软件的助理,肃清繁琐重复的任务,帮你深度挖掘文档内容。缺陷:

如果 AI 能帮你创造统统,那么成为创意事情者还有什么意义?目前,LLM 只能运行在强大的远程打算机上,常日是按 token 数收费或采取订阅制。免费工具:

Blender Chat Companion——(类似于 Blender Copilot)Blender 中的一个 ChatGPT 实现,专用于处理适当的任务。利用了 ChatGPT API,这须要付费。付费工具:

Genmo—— 承诺会实现「创意通用智能」,采取了多步过程并且全都可以通过谈天界面掌握。Blender Copilot——(类似于 Blender Chat Companion)Blender 中的一个 ChatGPT 实现,专用于处理适当的任务。利用了 ChatGPT API,这须要付费。注:还有一个即将推出的 ChatUSD—— 这是一个可以操作和管理 USD 的谈天机器人,这是由皮克斯最初创建的标准,用以统一和简化动画电影制作中的 3D 数据交流和并行化。目前没有更多干系了,但英伟达彷佛很欢迎这项标准并在推动其成为各种 3D 内容的标准,而不但是电影。

终于完结了!

内允许多,但我多数还是遗漏了一些东西。你以为还有什么内容有待补充或还有什么干系工具值得提及,请在评论区与我们分享。原文链接:https://diffusionpilot.blogspot.com/2023/09/overview-ai-animation.html#id_generative_video_models