MiLM-6B —— 小米 AI 大模型

MiLM-6B 是由小米开拓的一个大规模预演习措辞模型,参数规模为 64 亿。在 C-Eval 和 CMMLU 上均取得同尺寸最好的效果。 根据 C-Eval 给出的信息,MiLM-6B 模型在详细各科目成绩上,在 STEM(科学、技能、工程和数学教诲)全部 20 个科目中,计量师、物理、化学、生物等多个项目得到了较高的准确率。

Code Llama —— 基于 Llama 2 的 AI 代码天生大模型

Code Llama 是基于 Llama 2 的 AI 代码天生大模型,可根据代码和自然措辞提示天生代码和有关代码的自然措辞,支持多种主流编程措辞,包括 Python、C++、Java、PHP、Typescript (Javascript)、C# 和 Bash。 Code Llama 基于 Llama 2 大措辞模型打造,供应了三种模型: - Code Llama - 根本代码模型 - Code Llama - Python - 专门针对 Python 进行优化 - Code Llama - Instruct - 专门用于理解自然措辞指令 它们具有开放式模型中领先的性能、添补能力、对大型输入高下文的支持以及用于编程任务的零指令跟随能力。所有模型都是基于 16k 标记序列进行演习,并在最多 100k 标记输入上显示出改进。

通义千问-7B —— 基于 Transformer 的大措辞模型

通义千问 - 7B(Qwen-7B) 是阿里云研发的通义千问大模型系列的 70 亿参数规模的模型。Qwen-7B 是基于 Transformer 的大措辞模型,在超大规模的预演习数据上进行演习得到。预演习数据类型多样,覆盖广泛,包括大量网络文本、专业书本、代码等。同时,在 Qwen-7B 的根本上,利用对齐机制打造了基于大措辞模型的 AI 助手 Qwen-7B-Chat。Qwen-7B 系列模型的特点包括: - 大规模高质量预演习数据:利用了超过 2.2 万亿 token 的自建大规模预演习数据集进行措辞模型的预演习。数据集包括文本和代码等多种数据类型,覆盖通用领域和专业领域。 - 精良的模型性能:比较同规模的开源模型,Qwen-7B 在多个评测数据集上具有显著上风,乃至超出 12-13B 等更大规模的模型。评测评估的能力范围包括自然措辞理解与天生、数学运算解题、代码天生等。 - 更好地支持多措辞:基于更大词表的分词器在分词上更高效,同时它对其他措辞表现更加友好。用户可以在 Qwen-7B 的根本上更方便地演习特定措辞的 7B 措辞模型。 - 8K 的高下文长度:Qwen-7B 及 Qwen-7B-Chat 均能支持 8K 的高下文长度,许可用户输入更长的 prompt。 - 支持插件调用:Qwen-7B-Chat 针对插件调用干系的对齐数据做了特定优化,当前模型能有效调用插件以及升级为 Agent。

ChatGLM2-6B —— 开源双语对话措辞模型

ChatGLM2-6B 是开源中英双语对话模型 ChatGLM-6B 的第二代版本,在保留了初代模型对话流畅、支配门槛较低等浩瀚精良特性的根本之上,引入了如下新特性: - 更强大的性能:基于 ChatGLM 初代模型的开拓履历,全面升级了 ChatGLM2-6B 的基座模型。ChatGLM2-6B 利用了 GLM 的稠浊目标函数,经由了 1.4T 中英标识符的预演习与人类偏好对齐演习,评测结果显示,比较于初代模型,ChatGLM2-6B 在 MMLU(+23%)、CEval(+33%)、GSM8K(+571%) 、BBH(+60%)等数据集上的性能取得了大幅度的提升,在同尺寸开源模型中具有较强的竞争力。 - 更长的高下文:基于 FlashAttention 技能,将基座模型的高下文长度(Context Length)由 ChatGLM-6B 的 2K 扩展到了 32K,并在对话阶段利用 8K 的高下文长度演习,许可更多轮次的对话。但当前版本的 ChatGLM2-6B 对单轮超长文档的理解能力有限,会在后续迭代升级中着重进行优化。 - 更高效的推理:基于 Multi-Query Attention 技能,ChatGLM2-6B 有更高效的推理速率和更低的显存占用:在官方的模型实现下,推理速率比较初代提升了 42%,INT4 量化下,6G 显存支持的对话长度由 1K 提升到了 8K。 - 更开放的协议:ChatGLM2-6B 权重对学术研究完备开放,在得到官方的书面容许后,亦许可商业利用。

baichuan-7B —— 开源中英文大模型

baichuan-7B 是开源的大规模预演习模型,基于 Transformer 构造,在大约 1.2 万亿 tokens 上演习的 70 亿参数模型,支持中英双语,高下文窗口长度为 4096。

TigerBot —— 多措辞多任务大措辞模型

TigerBot 是一个多措辞多任务的大规模措辞模型 (LLM)。 根据 OpenAI InstructGPT 论文在公开 NLP 数据集上的自动评测,TigerBot-7B 达到 OpenAI 同样大小模型的综合表现的 96%。目前已开源: - 模型:TigerBot-7B, TigerBot-7B-base,TigerBot-180B (research version), - 代码:基本演习和推理代码,包括双卡推理 180B 模型的量化和推理代码, - 数据:预演习 100G,从 2TB 过滤后的数据中经由去噪去重洗濯而得;监督微调 1G 或 100 万条数据,按比例涵盖用户指令常见的 10 大类 120 小类任务, - API: chat, plugin, finetune, 让用户能在半小时内无代码的演习和利用专属于自己的大模型和数据, - 领域数据:涵盖金融,法律,百科,广邀大模型运用开拓者,一起打造中国的天下级的运用。

YuLan-Chat —— 基于中英文稠浊指令微调的大措辞对话模型

YuLan-Chat 是基于高质量中英文稠浊指令微调的大措辞对话模型。 YuLan-Chat 采取 LLaMA 作为底座,采取精心优化的高质量中英文稠浊指令进行微调。个中 YuLan-Chat-65B 模型目前能够在中英文干系评测数据集上显著超越已有开源模型效果。团队称后续会连续优化指令微调方法与底座模型,持续更新 YuLan-Chat 模型。

Falcon-40B —— 因果解码器大模型

Falcon-40B 是 400 亿参数的因果解码器模型,它在 RefinedWeb 的 1000B token 上进行演习,并利用精选数据集增强。它在 Huggingface 的 OpenLLM 排行榜上排首位,其性能优于 LLaMA、MPT、RedPajama 和 StableLM 等。 Falcon-40B 利用自定义工具构建,包含一个独特的数据管道,该管道从公开网络中提取演习数据。 Falcon 从公网上抓取内容构建好 Falcon 的初始预演习数据集后,再利用 CommonCrawl 转储,进行大量过滤(包括删除机器天生的文本和成人内容),并肃清重复数据,终极得到一个由近 5 万亿个 token 组成的弘大预演习数据集。

华佗GPT —— 开源中文医疗大模型

HuatuoGPT(华佗 GPT)是开源中文医疗大模型,基于年夜夫回答和 ChatGPT 回答,让措辞模型成为年夜夫,供应丰富且准确的问诊。 HuatuoGPT 致力于通过领悟 ChatGPT 天生的 “蒸馏数据” 和真实天下年夜夫回答的数据,以使措辞模型具备像年夜夫一样的诊断能力和供应有用信息的能力,同时保持对用户流畅的交互和内容的丰富性,对话更加丝滑。 HuatuoGPT 利用了四种不同的数据集,分别如下: - 蒸馏 ChatGPT 指令数据集(Distilled Instructions from ChatGPT):这个数据集受到 Alpaca 模型创建指令集的方法启示,从 ChatGPT 中提炼出医疗干系的指令。与之前事情不同的是,本方法还加入了科室和角色信息,根据采样的科室或角色天生符合条件的指令数据集。 - 真实年夜夫指令数据集(Real-world Instructions from Doctors):这个数据集来源于真实年夜夫和患者之间的问答。年夜夫的回答常日简洁且口语化,因此本方法通过润色以提高其可读性。 - 蒸馏 ChatGPT 对话数据集(Distilled Conversations from ChatGPT):这个数据集通过为两个 ChatGPT 模型供应共享的对话背景,让它们分别模拟年夜夫和患者进行对话。 - 真实年夜夫对话数据集(Real-world Conversations with Doctors):这个数据集来源于真实年夜夫的对话,但对年夜夫的回答利用模型进行了润色。 这些数据集共同为模型供应了一个统一的措辞模式、年夜夫的诊断能力以及指令跟随能力。

BLOOMChat —— 可商用多措辞谈天 LLM

BLOOMChat 是一个新的、开放的、多措辞的谈天 LLM。 SambaNova 和 Together 利用 SambaNova 独特的可重构数据流架构在 SambaNova DataScale 系统上演习了 BLOOMChat;其建立在 BigScience 组织的 BLOOM 之上,并在 OpenChatKit、Dolly 2.0 和 OASST1 的 OIG 上进行了微调。

CPM-Bee —— 中英文双语大措辞模型

CPM-Bee 是一个 完备开源、许可商用的百亿参数中英文基座模型。它采取 Transformer 自回归架构(auto-regressive),利用万亿级高质量语料进行预演习,拥有强大的根本能力。 CPM-Bee 的特点可以总结如下: 开源可商用:OpenBMB 始终秉承 “让大模型飞入千家万户” 的开源精神,CPM-Bee 基座模型将完备开源并且可商用,以推动大模型领域的发展。如需将模型用于商业用场,只需企业实名邮件申请并得到官方授权证书,即可商用利用。 中英双语性能精良:CPM-Bee 基座模型在预演习语料上进行了严格的筛选和配比,同时在中英双语上具有亮眼表现,详细可拜会评测任务和结果。 超大规模高质量语料:CPM-Bee 基座模型在万亿级语料上进行演习,是开源社区内经由语料最多的模型之一。同时,我们对预演习语料进行了严格的筛选、洗濯和后处理以确保质量。 OpenBMB 大模型系统生态支持:OpenBMB 大模型系统在高性能预演习、适配、压缩、支配、工具开拓了一系列工具,CPM-Bee 基座模型将配套所有的工具脚本,高效支持开拓者进行进阶利用。 强大的对话和工具利用能力:结合 OpenBMB 在指令微调和工具学习的探索,我们在 CPM-Bee 基座模型的根本上进行微调,演习出了具有强大对话和工具利用能力的实例模型,现已开放定向约请内测,未来会逐步向"大众年夜众开放。 CPM-Bee 的基座模型可以准确地进行语义理解,高效完成各种根本任务,包括:笔墨填空、文本天生、翻译、问答、评分预测、文本选择题等等。

MMS —— AI 语音识别大模型

Massively Multilingual Speech (MMS) 是 Meta 开源的 AI 语音识别模型,支持 1107 种措辞的语音转文本和文本转语音,以及 4000 多种措辞的措辞识别。 MMS 项目将支持的措辞数量增加了 10-40 倍,详细取决于任务。紧张身分是一个新的数据集,该数据集基于对公开宗教文本的阅读,并有效地利用了自我监督学习。

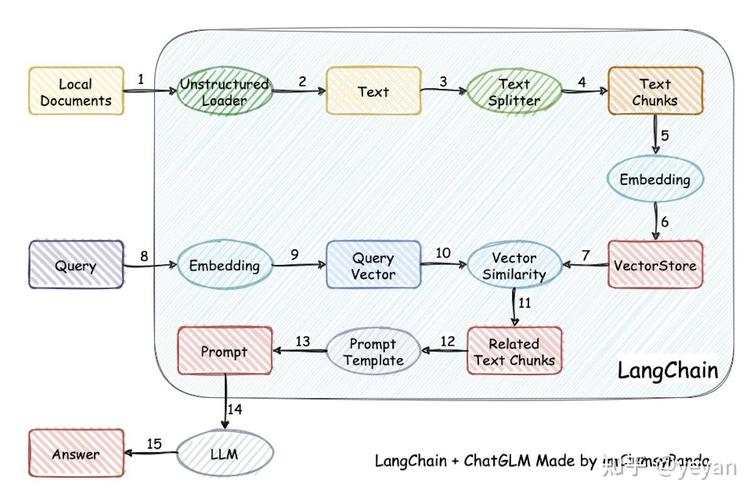

DB-GPT —— 数据库大措辞模型

DB-GPT 是一个开源的以数据库为根本的 GPT 实验项目,利用本地化的 GPT 大模型与数据和环境进行交互,无数据透露风险,100% 私密,100% 安全。 DB-GPT 为所有以数据库为根本的场景,构建了一套完全的私有大模型办理方案。 此方案由于支持本地支配,以是不仅仅可以运用于独立私有环境,而且还可以根据业务模块独立支配隔离,让大模型的能力绝对私有、安全、可控。

LaWGPT —— 基于中文法律知识的大措辞模型

LaWGPT 是一系列基于中文法律知识的开源大措辞模型。 该系列模型在通用中文基座模型(如 Chinese-LLaMA、ChatGLM 等)的根本上扩充法律领域专有词表、大规模中文法律语料预演习,增强了大模型在法律领域的根本语义理解能力。在此根本上,布局法律领域对话问答数据集、中国法律考试数据集进行指令精调,提升了模型对法律内容的理解和实行能力。

VisualGLM-6B —— 多模态对话措辞模型

VisualGLM-6B 是一个开源的,支持图像、中文和英文的多模态对话措辞模型,措辞模型基于 ChatGLM-6B,具有 62 亿参数;图像部分通过演习 BLIP2-Qformer 构建起视觉模型与措辞模型的桥梁,整体模型共 78 亿参数。 VisualGLM-6B 依赖来自于 CogView 数据集的 30M 高质量中文图文对,与 300M 经由筛选的英文图文对进行预演习,中英文权重相同。该演习办法较好地将视觉信息对齐到 ChatGLM 的语义空间;之后的微调阶段,模型在长视觉问答数据上演习,以天生符合人类偏好的答案。

Chinese BERT —— 中文预演习措辞模型

在自然措辞处理领域中,预演习措辞模型(Pre-trained Language Models)已成为非常主要的根本技能。 为了进一步促进中文信息处理的研究发展,我们发布了基于全词遮罩(Whole Word Masking)技能的中文预演习模型 BERT-wwm,以及与此技能密切干系的模型:BERT-wwm-ext,RoBERTa-wwm-ext,RoBERTa-wwm-ext-large, RBT3, RBTL3。

PERT —— 基于 BERT 的预演习措辞模型

PERT 提出了一种基于乱序措辞模型的预演习模型(PERT),在不引入掩码标记 [MASK] 的情形下自监督地学习文本语义信息。 PERT 在部分中英文 NLU 任务上得到性能提升,但也在部分任务上效果较差,请酌情利用。目前供应了中文和英文的 PERT 模型,包含两种模型大小(base、large)。

ChatDoctor —— 医学谈天模型

ChatDoctor 是一个利用医学领域知识在 LLaMA 模型上微调的医学谈天模型。

GPT Neo —— 开源 GPT 模型

GPT Neo 利用 mesh-tensorflow 库实现了 GPT 系列的措辞模型,个中包括 GPT-2 和 GPT-3,声称可以扩展到完全的 GPT-3 大小。

GPT4All —— GPT4 平替版本

GPT4All 是基于 LLaMa 的~800k GPT-3.5-Turbo Generations 演习出来的助手式大型措辞模型,这个模型接管了大量干净的助手数据的演习,包括代码、故事和对话,可作为 GPT4 的平替。

Chinese-BERT-wwm —— 中文 BERT-wwm 系列模型

Pre-Training with Whole Word Masking for Chinese BERT(中文 BERT-wwm 系列模型) 在自然措辞处理领域中,预演习措辞模型(Pre-trained Language Models)已成为非常主要的根本技能。为了进一步促进中文信息处理的研究发展,哈工大讯飞联合实验室(HFL)发布了基于全词遮罩(Whole Word Masking)技能的中文预演习模型 BERT-wwm,以及与此技能密切干系的模型:BERT-wwm-ext、RoBERTa-wwm-ext、RoBERTa-wwm-ext-large、RBT3、RBTL3。

LoRA —— 大型措辞模型的低秩适应

LoRA 是 Low-Rank Adaptation of Large Language Models 的简写,即大型措辞模型的低秩适应。它冻结了预演习模型的权重,并将可演习的秩分解矩阵注入到 Transformer 架构的每一层中,大大减少了下贱任务的可演习参数数量。 与利用 Adam 微调的 GPT-3 175B 比较,LoRA 可以减少 10,000 倍的可演习参数数量和 3 倍的 GPU 内存需求。LoRA 在 RoBERTa、DeBERTa、GPT-2 和 GPT-3 上的模型质量表现与微调相称或更好,只管可演习参数更少,演习吞吐量更高,而且与适配器不同,没有额外的推理延迟。 利用 RoBERTa (Liu et al., 2019) base and large 和 DeBERTa (He et al., 2020) XXL 1.5B 在 GLUE 基准上得到了与完备微调相称或优于完备微调的结果,同时只演习和存储了一小部分参数。

GLM —— 用于自然措辞理解和天生的通用预演习框架

GLM (General Language Model) 是清华大学推出的一种利用自回归填空目标进行预演习的通用措辞模型,可以针对各种自然措辞理解和天生任务进行微调。 GLM 通过添加 2D 位置编码并许可以任意顺序预测跨度来改进空缺添补预演习,从而在 NLU 任务上得到优于 BERT 和 T5 的性能。同时,GLM 可以通过改变空缺的数量和长度对不同类型的任务进行预演习。在横跨 NLU、条件和无条件天生的广泛任务上,GLM 在给定相同的模型大小和数据的情形下优于 BERT、T5 和 GPT,并从单一的预演习模型中得到了 1.25 倍 BERT Large 参数的最佳性能,表明其对不同下贱任务的通用性。 ChatGLM-6B 便是在 GLM 框架的根本上为中文 QA 和对话进行了优化。

CINO —— 少数民族措辞预演习模型

在自然措辞处理领域中,预演习措辞模型(Pre-trained Language Model, PLM)已成为主要的根本技能,在多措辞的研究中,预演习模型的利用也愈加普遍。为了促进中国少数民族措辞信息处理的研究与发展,哈工大讯飞联合实验室(HFL)发布少数民族措辞预演习模型 CINO (Chinese mINOrity PLM)。 本项事情的紧张贡献: CINO (Chinese mINOrity PLM) 基于多措辞预演习模型 XLM-R,在多种海内少数民族措辞语料上进行了二次预演习。该模型供应了藏语、蒙语(回鹘体)、维吾尔语、哈萨克语(阿拉伯体)、朝鲜语、壮语、粤语等少数民族措辞与方言的理解能力。 为了便于评价包括 CINO 在内的各个多措辞预演习模型性能,我们构建了基于维基百科的少数民族措辞分类任务数据集 Wiki-Chinese-Minority(WCM)。详细见少数民族措辞分类数据集。 通过实验证明,CINO 在 Wiki-Chinese-Minority(WCM)以及其他少数民族措辞数据集:藏语新闻分类 Tibetan News Classification Corpus (TNCC) 、朝鲜语新闻分类 KLUE-TC (YNAT) 上得到了最好的效果。干系结果详见实验结果。 该模型涵盖: Chinese,中文(zh) Tibetan,藏语(bo) Mongolian (Uighur form),蒙语(mn) Uyghur,维吾尔语(ug) Kazakh (Arabic form),哈萨克语(kk) Korean,朝鲜语(ko) Zhuang,壮语 Cantonese,粤语(yue)

VLE —— 视觉-措辞多模态预演习模型

VLE (Vision-Language Encoder) 是一种基于预演习文本和图像编码器的图像 - 文本多模态理解模型,可运用于如视觉问答、图像 - 文本检索等多模态判别任务。特殊地,在对措辞理解和推理能力有更强哀求的视觉知识推理(VCR)任务中,VLE 取得了公开模型中的最佳效果。 在线演示地址:https://huggingface.co/spaces/hfl/VQA_VLE_LLM VLE 模型采取双流构造,与 METER 模型构造类似,由两个单模态编码器(图像编码器和文本编码器)和一个跨模态领悟模块构成。VLE 与 METER 的构造上的差异在于: VLE 利用 DeBERTa-v3 作为文本编码器,其性能优于 METER 中利用的 RoBERTa-base。 在 VLE-large 中,跨模态领悟模块的隐层维度增加至 1024,以增加模型的容量。 在精调阶段,VLE 引入了额外的 token 类型向量表示。

MiniRBT —— 中文小型预演习模型

在自然措辞处理领域中,预演习措辞模型(Pre-trained Language Models)已成为非常主要的根本技能。为了进一步促进中文信息处理的研究发展,哈工大讯飞联合实验室(HFL)基于自主研发的知识蒸馏工具 TextBrewer,结合了全词掩码(Whole Word Masking)技能和知识蒸馏(Knowledge Distillation)技能推出中文小型预演习模型 MiniRBT。 MiniRBT 采取了如下技能: 全词掩码技能:全词掩码技能(Whole Word Masking)是预演习阶段的演习样本天生策略。大略来说,原有基于 WordPiece 的分词办法会把一个完全的词切分成多少个子词,在天生演习样本时,这些被分开的子词会随机被 mask(更换成 [MASK];保持原词汇;随机更换成其余一个词)。而在 WWM 中,如果一个完全的词的部分 WordPiece 子词被 mask,则同属该词的其他部分也会被 mask。更详细的解释及样例请参考:Chinese-BERT-wwm,本事情中利用了哈工大 LTP 作为分词工具。 两段式蒸馏:相较于西席模型直接蒸馏到学生模型的传统方法,该项目采取中间模型赞助西席模型到学生模型蒸馏的两段式蒸馏方法,即西席模型先蒸馏到助教模型(Teacher Assistant),学生模型通过对助教模型蒸馏得到,以此提升学生模型不才游任务的表现。并不才文中贴出了下贱任务上两段式蒸馏与一段式蒸馏的实验比拟,结果表明两段式蒸馏能取得比较一段式蒸馏更优的效果。 构建窄而深的学生模型。相较于宽而浅的网络构造,如 TinyBERT 构造(4 层,隐层维数 312),开拓团队构建了窄而深的网络构做作为学生模型 MiniRBT(6 层,隐层维数 256 和 288),实验表明窄而深的构造下贱任务表现更精良。

LLaVA —— 端到端演习的大型多模态模型

LLaVA 是一个面向多模态 GPT-4 级别功能构建的大型措辞和视觉助手。代表了一种端到端演习的大型多模态模型,连接视觉编码器和 LLM 以实现通用视觉和措辞理解。 早期实验表明,LLaVA 展示了精良的多模型谈天能力,有时在看不见的图像 / 指令上表现出多模型 GPT-4 的行为,与 GPT-4 比较,在合成的多模态指令跟随数据集中产生了 85.1% 的相对得分。当在 Science QA 上进行微调时,LLaVA 和 GPT-4 的协同浸染达到了 92.53% 的新的最前辈的准确率。LLaVA 团队公开了 GPT-4 天生的视觉指令调度数据、以及其模型和代码库。

mPLUG-Owl —— 多模态大措辞模型

阿里达摩院提出的多模态 GPT 的模型:mPLUG-Owl,基于 mPLUG 模块化的多模态大措辞模型。它不仅能理解推理文本的内容,还可以理解视觉信息,并且具备精良的跨模态对齐能力。 论文:https://arxiv.org/abs/2304.14178 DEMO:https://huggingface.co/spaces/MAGAer13/mPLUG-Owl

PaLM 2 —— 谷歌下一代大型措辞模型

PaLM 2 是谷歌推出的下一代大型措辞模型。善于高等推理任务,包括代码和数学、分类和问答、翻译和多措辞能力以及自然措辞天生。 谷歌声称 PaLM 2 是一种最前辈的措辞模型,要优于其之前所有的 LLM,包括 PaLM。目前,PaLM 2 已被用于 Med-PaLM 2 和 Sec-PaLM,并为谷歌的天生人工智能功能和工具(如 Bard 和 PaLM API)供应支持。

OpenLLaMA LLaMA —— 大措辞模型的开源复现版本

OpenLLaMA 是 Meta AI 的 LLaMA 大措辞模型的开源复现版本,采取宽松容许证。 仓库包含经由演习的 2000 亿标记的 7B OpenLLaMA 模型的公共预览版,并供应了预演习的 OpenLLaMA 模型的 PyTorch 和 Jax 权重,以及评估结果和与原始 LLaMA 模型的比较。

YaLM 100B —— 千亿参数预演习措辞模型

YaLM 100B 是一个类似 GPT 的神经网络,用于天生和处理文本。 该模型利用了 1000 亿个参数,在 800 个 A100 显卡和 1.7 TB 在线文本、书本以及海量其他英文和俄文资源的集群上演习该模型花了 65 天韶光。

WizardLM —— 基于 LLaMA 的微调大措辞模型

WizardLM 是一个经由微调的 7B LLaMA 模型。它通过大量具有不同难度的指令跟随对话进行微调。这个模型的新颖之处在于利用了 LLM 来自动天生演习数据。 WizardLM 模型利用一种名为 Evol-Instruct(是一种利用 LLM 代人类自主批天生各种难度等级和技能范围的开放指令,以提高 LLM 能力的新方法)的新方法,通过 70k 个打算机天生的指令进行演习,该方法天生具有不同难度级别的指令。

Web LLM —— 将大措辞模型谈天直接带到 Web 浏览器上

Web LLM 是一个可将大型措辞模型和基于 LLM 的谈天机器人引入 Web 浏览器的项目。统统都在浏览器内运行,无需做事器支持,并利用 WebGPU 加速。这开辟了许多有趣的机会,可以为每个人构建 AI 助手,并在享受 GPU 加速的同时实现隐私。

MLC LLM —— 本地大措辞模型

MLC LLM 是一种通用办理方案,它许可将任何措辞模型本地支配在各种硬件后端和本地运用程序上。 此外,MLC LLM 还供应了一个高效的框架,供给用者根据需求进一步优化模型性能。MLC LLM 旨在让每个人都能在个人设备受骗地开拓、优化和支配 AI 模型,而无需做事器支持,并通过手机和条记本电脑上的消费级 GPU 进行加速。

SantaCoder —— 轻量级 AI 编程模型

SantaCoder 是一个措辞模型,该模型拥有 11 亿个参数,可以用于 Python、Java 和 JavaScript 这几种编程措辞的代码天生和补全建议。 根据官方供应的信息,演习 SantaCoder 的根本是 The Stack(v1.1)数据集,SantaCoder 虽然规模相对较小,只有 11 亿个参数,在参数的绝对数量上低于 InCoder(67 亿)或 CodeGen-multi(27 亿),但 SantaCoder 的表现则是要远好于这些大型多措辞模型。

StarCoder —— 代码天生措辞模型

StarCoder(150 亿参数)是 Hugging Face 联合 ServiceNow 发布的免费大型措辞模型,该模型经由演习紧张用场是可以天生代码,目的是为了对抗 GitHub Copilot 和亚马逊 CodeWhisperer 等基于 AI 的编程工具。

StableLM —— Stability AI 开拓的措辞模型

StableLM 项目仓库包含 Stability AI 正在进行的 StableLM 系列措辞模型开拓,目前 Stability AI 发布了初始的 StableLM-alpha 模型集,具有 30 亿和 70 亿参数。150 亿和 300 亿参数的模型正在开拓中。 StableLM 模型可以天生文本和代码,并为一系列下贱运用供应支持。它们展示了小而高效的模型如何在适当的演习下供应高性能。

RedPajama —— 大措辞模型

RedPajama 项目旨在创建一套领先的全开源大措辞模型。目前,该项目已完成了第一步,成功复制了 LLaMA 演习数据集超过 1.2 万亿个数据 token。该项目由 Together、Ontocord.ai、ETH DS3Lab、斯坦福大学 CRFM、Hazy Research 和 MILA 魁北克 AI 研究所联合开拓。 RedPajama 包含三个紧张组成部分:预演习数据、根本模型和指令调优数据与模型。

Vicuna —— 达到 ChatGPT/Bard 90% 水平的谈天机器人

Vicuna 模型对 LLaMA 进行了微调,由加州大学伯克利分校、卡内基梅隆大学、斯坦福大学、加州大学圣地亚哥分校和 MBZUAI 的学术团队进行微调演习而成,有两种大小可供选择:7B 和 13B。 Vicuna-13B 与 Stanford Alpaca 等其他开源模型比较展示了具有竞争力的性能。 以 GPT-4 为评判标准的初步评估显示,Vicuna-13B 达到了 OpenAI ChatGPT 和 Google Bard 90% 以上的质量,同时在 90% 以上的情形下超过了 LLaMA 和 Stanford Alpaca 等其他模型的表现。演习 Vicuna-13B 本钱约为 300 美元。演习和做事代码,以及在线演示都是公开的,可用于非商业用场。

CodeGeeX —— 多措辞代码天生模型

CodeGeeX 是一个具有 130 亿参数的多编程措辞代码天生预演习模型。CodeGeeX 采取华为 MindSpore 框架实现,在鹏城实验室 “鹏城云脑 II” 中的 192 个节点(共 1536 个国产昇腾 910 AI 处理器)上演习而成。 CodeGeeX 有以下特点: 高精度代码天生:支持天生 Python、C++、Java、JavaScript 和 Go 等多种主流编程措辞的代码,在 HumanEval-X 代码天生任务上取得 47%~60% 求解率,较其他开源基线模型有更佳的均匀性能。 跨措辞代码翻译:支持代码片段在不同编程措辞间进行自动翻译转换,翻译结果精确率高,在 HumanEval-X 代码翻译任务上超越了其它基线模型。 自动编程插件:CodeGeeX 插件现已上架 VSCode 插件市场(完备免费),用户可以通过其强大的少样本天生能力,自定义代码天生风格和能力,更好赞助代码编写。 模型跨平台开源:所有代码和模型权重开源开放,用作研究用场。CodeGeeX 同时支持昇腾和英伟达平台,可在单张昇腾 910 或英伟达 V100/A100 上实现推理。

Chinese-Vicuna —— 基于 LLaMA 的中文大措辞模型

Chinese-Vicuna 是一个中文低资源的 LLaMA+Lora 方案。 项目包括: finetune 模型的代码 推理的代码 仅利用 CPU 推理的代码 (利用 C++) 下载 / 转换 / 量化 Facebook llama.ckpt 的工具 其他运用

BELLE —— 开源中文对话大模型

BELLE: Be Everyone's Large Language model Engine(开源中文对话大模型) 本项目目标是促进中文对话大模型开源社区的发展,愿景做能帮到每一个人的 LLM Engine。现阶段本项目基于一些开源预演习大措辞模型(如 BLOOM),针对中文做了优化,模型调优仅利用由 ChatGPT 生产的数据(不包含任何其他数据)。

BBT-2 —— 通用大措辞模型

BBT-2 是包含 120 亿参数的通用大措辞模型,在 BBT-2 的根本上演习出了代码,金融,文生图等专业模型。基于 BBT-2 的系列模型包括: BBT-2-12B-Text:120 亿参数的中文根本模型 BBT-2.5-13B-Text: 130 亿参数的中文 + 英文双语根本模型 BBT-2-12B-TC-001-SFT 经由指令微调的代码模型,可以进行对话 BBT-2-12B-TF-001 在 120 亿模型上演习的金融模型,用于办理金融领域任务 BBT-2-12B-Fig:文生图模型 BBT-2-12B-Science 科学论文模型

本草 —— 基于中文医学知识的 LLaMA 微调模型

本草【原名:华驼 (HuaTuo)】是基于中文医学知识的 LLaMA 微调模型。 此项目开源了经由中文医学指令精调 / 指令微调 (Instruct-tuning) 的 LLaMA-7B 模型。通过医学知识图谱和 GPT3.5 API 构建了中文医学指令数据集,并在此根本上对 LLaMA 进行了指令微调,提高了 LLaMA 在医疗领域的问答效果。

ChatGLM-6B —— 开源双语对话措辞模型

ChatGLM-6B 是一个开源的、支持中英双语问答的对话措辞模型,并针对中文进行了优化。该模型基于 General Language Model (GLM) 架构,具有 62 亿参数。结合模型量化技能,用户可以在消费级的显卡上进行本地支配(INT4 量化级别下最低只需 6GB 显存)。 ChatGLM-6B 利用了和 ChatGLM 相同的技能,针对中文问答和对话进行了优化。经由约 1T 标识符的中英双语演习,辅以监督微调、反馈自助、人类反馈强化学习等技能的加持,62 亿参数的 ChatGLM-6B 虽然规模不及千亿模型,但大大降落了推理本钱,提升了效率,并且已经能天生相称符合人类偏好的回答。

伶荔Linly —— 大规模中文措辞模型

比较已有的中文开源模型,伶荔模型具有以下上风: 在 32A100 GPU 上演习了不同量级和功能的中文模型,对模型充分演习并供应强大的 baseline。据知,33B 的 Linly-Chinese-LLAMA 是目前最大的中文 LLaMA 模型。 公开所有演习数据、代码、参数细节以及实验结果,确保项目的可复现性,用户可以选择得当的资源直接用于自己的流程中。 项目具有高兼容性和易用性,供应可用于 CUDA 和 CPU 的量化推理框架,并支持 Huggingface 格式。 目前公开可用的模型有: Linly-Chinese-LLaMA:中文根本模型,基于 LLaMA 在高质量中文语料上增量演习强化中文措辞能力,现已开放 7B、13B 和 33B 量级,65B 正在演习中。 Linly-ChatFlow:中文对话模型,在 400 万指令数据凑集上对中文根本模型指令精调,现已开放 7B、13B 对话模型。 Linly-ChatFlow-int4 :ChatFlow 4-bit 量化版本,用于在 CPU 上支配模型推理。 进行中的项目: Linly-Chinese-BLOOM:基于 BLOOM 中文增量演习的中文根本模型,包含 7B 和 175B 模型量级,可用于商业场景。

MOSS —— 对话大措辞模型

MOSS 是一个支持中英双语和多种插件的开源对话措辞模型, moss-moon 系列模型具有 160 亿参数,在 FP16 精度下可在单张 A100/A800 或两张 3090 显卡运行,在 INT4/8 精度下可在单张 3090 显卡运行。 MOSS 基座措辞模型在约七千亿中英文以及代码单词上预演习得到,后续经由对话指令微调、插件增强学习和人类偏好演习具备多轮对话能力及利用多种插件的能力。

白泽Baize —— 利用 LoRA 演习的大措辞模型

白泽是利用 LoRA 演习的开源谈天模型,它改进了开源大型措辞模型 LLaMA,通过利用新天生的谈天语料库对 LLaMA 进行微调,该模型在单个 GPU 上运行,使其可供更广泛的研究职员利用。 白泽目前包括四种英语模型:白泽 -7B、13B 和 30B(通用对话模型),以及一个垂直领域的白泽 - 医疗模型,供研究 / 非商业用场利用,并操持在未来发布中文的白泽模型。 白泽的数据处理、演习模型、Demo 等全部代码已经开源。

悟道 —— 双语多模态大措辞模型

“悟道” 是双语多模态预演习模型,规模达到 1.75 万亿参数。项目现有 7 个开源模型成果。 图文类 1、CogView 参数量为 40 亿,模型可实现文本天生图像,经由微调后可实现国画、油画、水彩画、轮廓画等图像天生。目前在公认 MS COCO 文生图任务上取得了超过 OpenAI DALL・E 的成绩,得到天下第一。 2、BriVL (Bridging Vision and Language Model) 是首个中文通用图文多模态大规模预演习模型。BriVL 模型在图文检索任务上有着精良的效果,超过了同期其他常见的多模态预演习模型(例如 UNITER、CLIP)。 文本类 1、GLM 因此英文为核心的预演习措辞模型系列,基于新的预演习范式实现单一模型在措辞理解和天生任务方面取得了最佳结果,并且超过了在相同数据量进行演习的常见预演习模型(例如 BERT,RoBERTa 和 T5),目前已开源 1.1 亿、3.35 亿、4.10 亿、5.15 亿、100 亿参数规模的模型。 2、CPM 系列模型是兼顾理解与天生能力的预演习措辞模型系列,涵盖中文、中英双语多类模型,目前已开源 26 亿、110 亿和 1980 亿参数规模的模型。 3、Transformer-XL 因此中文为核心的预演习措辞天生模型,参数规模为 29 亿,目前可支持包括文章天生、智能作诗、评论 / 择要天生等主流 NLG 任务。 4、EVA 是一个开放领域的中文对话预演习模型,是目前最大的汉语对话模型,参数量达到 28 亿,并且在包括不同领域 14 亿汉语的悟道对话数据集(WDC)上进行预演习。 5、Lawformer 是天下创始法律领域长文本中文预演习模型,参数规模达到 1 亿。 蛋白质类 1、ProtTrans 是海内最大的蛋白质预演习模型,参数总量达到 30 亿。

PanGu-Dialog —— 对话天生大模型

鹏程・盘古对话天生大模型 (PanGu-Dialog)。 PanGu-Dialog 因此大数据和大模型为显著特色的大规模开放域对话天生模型,充分利用大规模预演习措辞模型的知识和措辞能力,构建可控、可靠可信、有聪慧的自然人机对话模型。紧张特性如下: 首次提出对话聪慧度以探索对话模型的逻辑推理、数据打算、遐想、创作等方面的能力。 构建了覆盖领域最广 (据我们所知) 的开放域交互式对话评估数据集 PGCED,12 个领域,并在知识性、安全性、聪慧程度等方面制作了针对性的评测数据。 基于预演习 + 持续微调的学习策略领悟大规模普通文本和多种对话数据演习而成,充分利用演习措辞模型措辞能力和知识,高效构建强大的对话模型。 在各项指标上达到了中文纯模型天生式对话 SOTA 水平,在知识性和信息量方面上风明显,但安全性、可靠、可信、可控、聪慧等方面的提升并不明显。 目前天生式对话仍处于较低水平,与人类对话能力存在明显的差距,后续将在现有根本上针对不同的维度不断优化迭代,不断进步。

鹏程·盘古α —— 中文预演习措辞模型

「鹏程・盘古 α」是业界首个 2000 亿参数以中文为核心的预演习天生措辞模型,目前开源了两个版本:鹏程・盘古 α 和鹏程・盘古 α 增强版,并支持 NPU 和 GPU 两个版本,支持丰富的场景运用,在知识问答、知识检索、知识推理、阅读理解等文本天生领域表现突出,具备较强的少样本学习的能力。 基于盘古系列大模型供应大模型运用落地技能帮助用户高效的落地超大预演习模型到实际场景。 紧张有如下几个核心模块: 数据集:从开源开放数据集、common crawl 数据集、电子书等网络近 80TB 原始语料,构建了约 1.1TB 的高质量中文语料数据集、53 种语种高质量单、双语数据集 2TB。 根本模块:供应预演习模型库,支持常用的中文预演习模型,包括鹏程・盘古 α、鹏程・盘古 α 增强版等。 运用层:支持常见的 NLP 运用比如多措辞翻译、开放域对话等,支持预演习模型落地工具,包括模型压缩、框架移植、可持续学习,助力大模型快速落地。

Chinese-LLaMA-Alpaca —— 中文 LLaMA & Alpaca 大模型

Chinese-LLaMA-Alpaca 包含中文 LLaMA 模型和经由指令微调的 Alpaca 大型模型。 这些模型在原始 LLaMA 的根本上,扩展了中文词汇表并利用中文数据进行二次预演习,从而进一步提高了对中文基本语义理解的能力。同时,中文 Alpaca 模型还进一步利用中文指令数据进行微调,明显提高了模型对指令理解和实行的能力。

Stanford Alpaca —— 指令调优的 LLaMA 模型

Stanford Alpaca(斯坦福 Alpaca)是一个指令调优的 LLaMA 模型,从 Meta 的大措辞模型 LLaMA 7B 微调而来。 Stanford Alpaca 让 OpenAI 的 text-davinci-003 模型以 self-instruct 办法天生 52K 指令遵照(instruction-following)样本,以此作为 Alpaca 的演习数据。研究团队已将演习数据、天生演习数据的代码和超参数开源,后续还将发布模型权重和演习代码。

Lit-LLaMA ️ —— 基于 nanoGPT 的措辞模型

Lit-LLaMA 是一个基于 nanoGPT 的 LLaMA 措辞模型的实现,支持量化、LoRA 微调、预演习。 紧张特点:单一文件实现,没有样板代码;在消费者硬件上或大规模运行;在数值上等同于原始模型

Dolly —— 低本钱大措辞模型

Dolly 是一个低本钱的 LLM,Dolly 采取 EleutherAI 现有的 60 亿参数的开源模型,并对其进行细微的修正,以引发指令跟随能力。 只管模型小得多,只有 60 亿个参数,以及较小的数据集和演习韶光(ChatGPT 的参数是 1750 亿个),但 Dolly 仍旧表现出了 ChatGPT 所展示的同样的 "神奇的人类互动能力"。

ChatYuan —— 对话措辞大模型

ChatYuan 是一个支持中英双语的功能型对话措辞大模型。ChatYuan-large-v2 利用了和 v1 版本相同的技能方案,在微调数据、人类反馈强化学习、思维链等方面进行了优化。 ChatYuan-large-v2 是 ChatYuan 系列中以轻量化实现高质量效果的模型之一,用户可以在消费级显卡、 PC 乃至手机上进行推理(INT4 最低只需 400M )。

RWKV-LM —— 线性 Transformer 模型

RWKV 是结合了 RNN 和 Transformer 的措辞模型,适宜长文本,运行速率较快,拟合性能较好,占用显存较少,演习用时较少。 RWKV 整体构造依然采取 Transformer Block 的思路,相较于原始 Transformer Block 的构造,RWKV 将 self-attention 更换为 Position Encoding 和 TimeMix,将 FFN 更换为 ChannelMix。别的部分与 Transfomer 同等。

GPT-J —— 自然措辞处理 AI 模型

GPT-J 是一个基于 GPT-3,由 60 亿个参数组成的自然措辞处理 AI 模型。该模型在一个 800GB 的开源文本数据集上进行演习,并且能够与类似规模的 GPT-3 模型相媲美。 该模型通过利用 Google Cloud 的 v3-256 TPU 以及 EleutherAI 的 The Pile 数据集进行演习,历时大约五周韶光。GPT-J 在标准 NLP 基准事情负载上实现了与 OpenAI 报告的 67 亿参数版本的 GPT-3 类似的准确性。模型代码、预演习的权重文件、Colab 文档和一个演示网页都包含在 EleutherAI 的开源项目中。

OPT-175B —— Meta 开源的大措辞模型

OPT-175B 是 Meta 开源的大措辞模型,拥有超过 1750 亿个参数 —— 和 GPT-3 相称。比较 GPT-3,OPT-175B 的上风在于它完备免费。 Meta 还公布了代码库、开拓过程日志、数据、研究论文和其他与 OPT-175B 干系的信息。 只管 OPT-175B 是免费的,但 Meta 也给出了一些限定。为了防止误用和 “保持完全性”,OPT-175B 只许可在非商业用场下利用。也便是说,OPT-175B 的多数运用处景还是在科研上。

Cerebras-GPT —— 自然措辞处理领域大模型

Cerebras GPT 是由 Cerebras 公司开源的自然措辞处理领域的预演习大模型,其模型参数规模最小 1.11 亿,最大 130 亿,共 7 个模型。 与业界的模型比较,Cerebras-GPT 险些是各个方面完备公开,没有任何限定。不管是模型架构,还是预演习结果都是公开的。

BLOOM —— 自然措辞处理大模型

Bloom 是用于自然措辞处理的大措辞模型,包含 1760 亿个参数,支持 46 种自然措辞(包括中文)和 13 种编程措辞,可以用来回答问题、翻译文本、从文件中提取信息片段,还能像 GitHub Copilot 一样用于天生代码。 BLOOM 模型的最大上风是它的易获取性,任何个人或机构都可以从 Hugging Face 免费得到 1760 亿个参数的完全模型。用户有多个语种可选,然后将需求输入到 BLOOM 中,任务类型包括撰写食谱或诗歌、翻译或总结文本,乃至还有代码编程。人工智能开拓者可以在该模型的根本上构建他们自己的运用程序。

LLaMA —— Meta 大措辞模型

LLaMA 措辞模型全称为 "Large Language Model Meta AI",是 Meta 的全新大型措辞模型(LLM),这是一个模型系列,根据参数规模进行了划分(分为 70 亿、130 亿、330 亿和 650 亿参数不等)。 个中 LaMA-13B(130 亿参数的模型)只管模型参数比较 OpenAI 的 GPT-3(1750 亿参数) 要少了十几倍,但在性能上反而可以超过 GPT-3 模型。更小的模型也意味着开拓者可以在 PC 乃至是智好手机等设备受骗地运行类 ChatGPT 这样的 AI 助手,无需依赖数据中央这样的大规模举动步伐。

GPT-2 —— 基于 Transformer 的大型措辞模型

GPT-2 是一种基于 transformer 的大型措辞模型,具有 15 亿个参数,在 800 万网页数据集上进行演习。GPT-2 能够翻译文本、回答问题、总结段落,并天生文本输出。虽然其输出内容有时与人类相似,但在天生长段落时输出内容可能会变得重复或无意义。GPT-2 是一个通用学习器,没有经由专门演习来实行任何特定的任务,并且是作为 OpenAI 2018 GPT 模型的“直接扩展”而创建的,其参数数量和演习数据集的大小均增加了十倍。